综述

最近在研究有关多任务学习(multi-task learning)方面,看到了与多任务学习密切联系的元学习、迁移学习和小样本学习的相关对比,但是对这几个学习方式的共同点和区别不是很理解,这里简要做一些分析对比。受限于知识水平,本文内容可能会有错误,还请各位批评指正。

1.元学习(meta learning)

通常在机器学习里,我们会使用某个场景的大量数据来训练模型;然而当场景发生改变,模型就需要重新训练。但是对于人类而言,一个小朋友成长过程中会见过许多物体的照片,某一天,当Ta(第一次)仅仅看了几张狗的照片,就可以很好地对狗和其他物体进行区分。

元学习(Meta Learning),含义为学会学习,即learn to learn,就是带着这种对人类这种“学习能力”的期望诞生的。Meta Learning希望使得模型获取一种“学会学习”的能力,使其可以在获取已有“知识”的基础上快速学习新的任务,如:

- 让Alphago迅速学会下象棋

- 让一个猫咪图片分类器,迅速具有分类其他物体的能力

简单来说,就是为了让模型具有一种学会学习调参的能力,使其可以在获取已有知识的基础上快速学习新的任务。而元学习的目标就是对这种能力进行学习。

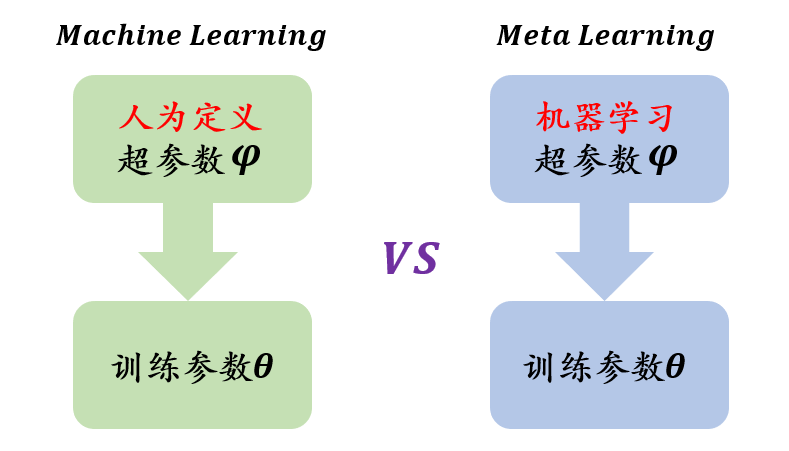

元学习与普通监督学习的对比图如下:

从上面我们可以看到,元学习方式可以通过机器自动去学习需要定义的超参数,而不同的参数也意味着不同的任务。

- 机器学习和元学习的目的都是找一个Function,只是两个Function功能不同。

- 机器学习中的Function直接作用于特征和标签,是学习某个数据分布x到另一个分布Y的映射。

- 元学习学习的Function是用于寻找新的f,新的f才会应用于具体任务,是某个任务集合D到每个任务对应的最优函数f的映射,

对应到目前正在研究的社交机器人检测方面,娱乐领域的社交机器人和政治领域的社交机器人显然其所发的推文的语义空间并不是会在一起,如果将其作为一个数据集去监督训练一个模型,有可能会导致与正常用户的语义空间有所交叉,降低准确率。如果我们把不同的领域机器人分别学习一个基础分类模型,在根据不同的领域进行泛化,那么其准确率就有可能上升。

元学习是属于多任务学习(multi-task learning),因此它需要收集多个类似任务的数据集。比如针对图片二分类任务,我们需要收集橙子和苹果训练数据和测试数据、自行车和汽车的训练数据和测试数据等等许多二分类任务的数据集。对应到社交机器人领域的话,我们可以收集娱乐、政治等类似任务作为多个数据集。

系统性的定义元学习,那么元学习的目标是:利用找到最优的超参,使各任务在超参的基础上训练出最优参数后测试得到的损失值的和最小。这句话讲起来比较难以理解,举个例子比较好明白:对于苹果和橙子的分类任务,在超参的基础上利用训练数据集进行训练,得到最优参数,然后再利用测试数据集对训练后的模型进行测试,测试得到的损失值是;同理,可以得到自行车和汽车分类任务的测试损失值,以及其他二分类任务的测试损失值;元学习的目标就是要找到最优超参,使所有任务的测试损失值之和最小。所以元学习的损失函数定义为:

这里每一个用于训练超参的任务都称为训练任务,上面的指所有训练任务的总数。如果在拿一个新的任务(该任务未在训练任务中出现过)来测试通过训练找到的超参的效果,那么这个任务就称为测试任务。

我们可以看到在每一个训练任务中包含了训练数据和测试数据,当然在测试任务中也包含了训练数据和测试数据,这和普通机器学习是大不同的。这样听起来很容易让人迷糊,所以有的文献不叫训练数据和测试数据,而是把训练数据叫支持集(support set),把测试数据叫查询集(query set)。

比较经典的元学习算法有:MAML、Reptile等,后续在深入。

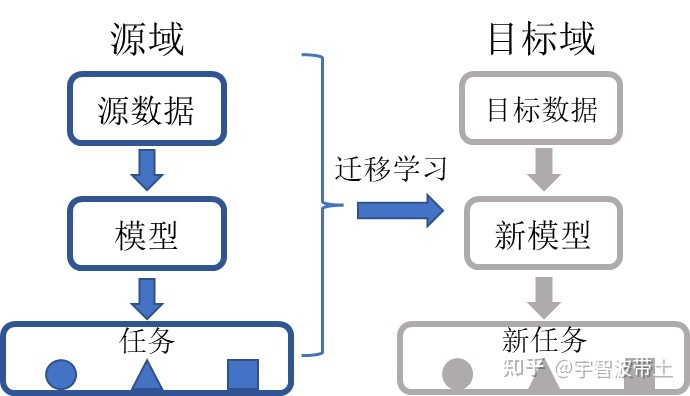

2.迁移学习(transfer learning)

迁移学习,对于人类来说,就是掌握举一反三的学习能力。比如我们学会骑自行车后,学骑摩托车就很简单了;在学会打羽毛球之后,再学打网球也就没那么难了。对于计算机而言,所谓迁移学习,就是能让现有的模型算法稍加调整即可应用于一个新的领域和功能的一项技术。

迁移学习通常会关注有一个源域和一个目标域的情况,其中源域使用表示, 分别表示数据样本和对应的类别标签,目标域使用表示。

在了解了迁移学习中的源域和目标域后,迁移学习的定义如下:

给定源域和学习任务、目标域和学习任务,迁移学习的目的是获取源域和学习任务中的知识以帮助提升目标域中的预测函数 的学习,其中或者。

如何实现迁移学习呢?

- 归纳迁移学习:在源领域和任务上学习出一般的规律,然后将这个规律迁移到目标领域和任务上

- 转导迁移学习:一种从样本到样本的迁移,直接利用源领域和目标领域的样本进行迁移学习.

- 无监督迁移学习:

一、归纳迁移学习。

归纳迁移学习是比较常见的方式,在图像领域与自然语言处理都有较多的应用。

- CV:源领域任务一般是大量有标注的数据。比如ImageNet,动机是神经网络底层的特征是图像中比较有共性的特征,高层才是比较有领域代表性的特征。

- NLP:源领域数据一般是没有标注的大规模语料。比如维基百科、微博等等。然后利用语言模型、设计相应的训练任务(比如bert的masked word以及next sentence prediction等)。简单来说,将大规模文本上的无监督学习(比如语言模型)中学到的知识迁移到一个新的目标任务上。

归纳迁移学习的两种迁移方式:

- 基于特征的方式:将预训练模型的输出或者是中间隐藏层的输出作为特征直接加入到目标任务的学习模型中。目标任务的学习模型可以是一般的浅层分类器(比如支持向量机等)或一个新的神经网络模型。

这里感觉word2vec这种词向量就是将中间的权重矩阵取出,作为目标任务的第一层(embedding),应该算是基于特征的方式。 - 精调的方式(Fine-Tuning):在目标任务上复用预训练模型的部分组件,并对其参数进行精调。

目前比如bert这样的预训练语言模型,就是用这种方式,通常就是将最后几层输出进行一些操作,拼到特定的任务上,比如分类、序列标注、阅读理解、句子相似度计算等。

二、转导迁移学习。

-

转导迁移学习通常假设源领域有大量的标注数据,而目标领域没有(或只有少量)标注数据,但是有大量的无标注数据.目标领域的数据在训练阶段是可见的。

-

领域指的是一个样本空间及其数据分布。只要三者中有不同,就是不同领域。

-

转导迁移的一个子问题就是领域适应问题(Adaptation)。在领域适应问题中,一般假设源领域和目标领域有相同的样本空间,但是数据分布不同。

-

根据贝叶斯公式,也可以分为不同的情况。。

大多数研究集中在相同,不同的情况。又称为协变量偏移。 -

这种问题的关键是在于如何找到领域无关的表征。

- 思路1:学习的目标是找到这样的特征,使得其在源领域数据集上损失小

- 思路2:对抗训练,找到这样的特征,使得源领域识别器与目标领域识别器无法区分该特征的对应领域。

-

具体细节不看,来看看与关系抽取中fewrel 数据集的关系。

源领域-训练集;目标领域-验证集。

- 训练集-验证集的输入输出形式相同,但是类别完全不同。

- 如果是1.0数据集,都是基于相同知识库构造的。说明语料是相同分布的,只是标签不同。也就是相同,但是学习任务有所区别。这是一个概念偏移问题。但在2.0数据集中,验证集就是其他领域数据构造的,协变量偏移问题。说明从转导迁移的角度,既要学习到领域无关的特征,也需要解决概念偏移问题。

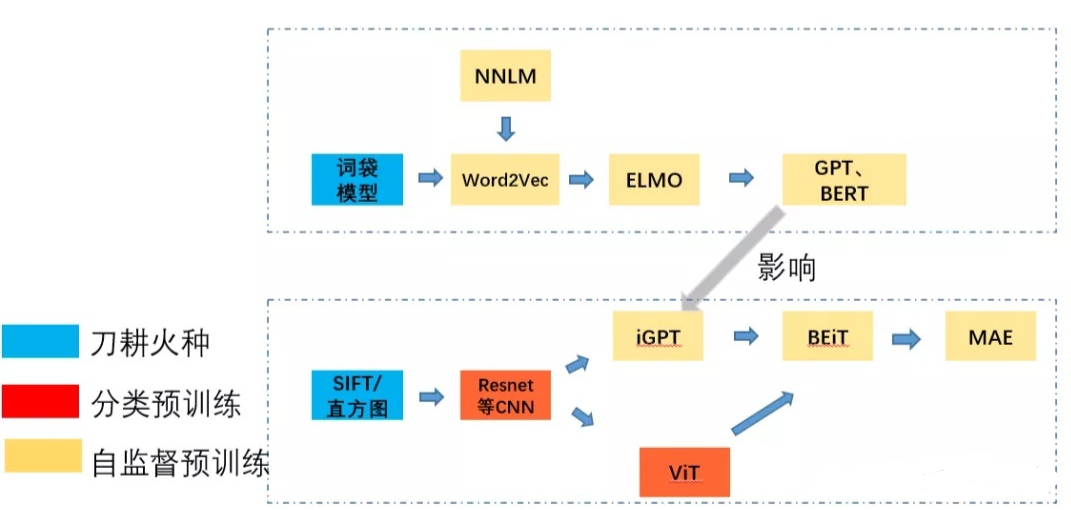

3.预训练(model pretrained)

预训练模型是迁移学习的一种应用。

当神经网络在用数据训练模型时,在数据中获取到的信息,其本质就是多层网络一个的权重。将权重提取出来,迁移到其它网络中,其它的网络便学来了这个网络的特征和其所拥有的知识。简单概括来说就是使用尽可能多的训练数据,从中提取出尽可能多的共性特征,从而让模型对特定任务的学习负担变轻。

这和小孩子读书一样,一开始语文、数学、化学都学,读书、网上游戏等,在脑子里积攒了很多。当他学习计算机时,实际上把他以前学到的所有知识都带进去了。如果他以前没上过中学,没上过小学,突然学计算机就不懂这里有什么道理。这和我们预训练模型一样,预训练模型就意味着把人类的语言知识,先学了一个东西,然后再代入到某个具体任务,就顺手了,就是这么一个简单的道理。

即使新问题和新任务与原始任务完全不同,学习到的特征在不同问题之间是可移植的,这也是深度学习与浅层学习方法的一个重要优势。它使得深度学习对于小数据问题非常的有效。

对于文本语言来说,是有天然的标注特征的存在的,原因就在于文本可以根据之前的输入词语进行预测,而且文本大多是有很多词语,所以就可以构成很大的预训练数据,进而可以自监督(不是无监督,因为词语学习过程是依据之前词语的输出的,所以应该是自监督学习)的预训练。例如之前笔者由做过将ResNet网络结合到BERT的MASK任务和NSP任务上进行预测,虽然最后结果并不理想,但是讨论了BERT内部的自监督学习方式。

预训练通过自监督学习从大规模数据中获得与具体任务无关的预训练模型。体现某一个词在一个特定上下文中的语义表征。第二个步骤是微调,针对具体的任务修正网络。训练数据可以是文本、文本-图像对、文本-视频对。预训练模型的训练方法可使用自监督学习技术(如自回归的语言模型和自编码技术)。可训练单语言、多语言和多模态的模型。此类模型可经过微调之后,用于支持分类、序列标记、结构预测和序列生成等各项技术,并构建文摘、机器翻译、图片检索、视频注释等应用。

为什么我们要做预训练模型?首先,预训练模型是一种迁移学习的应用,利用几乎无限的文本,学习输入句子的每一个成员的上下文相关的表示,它隐式地学习到了通用的语法语义知识。第二,它可以将从开放领域学到的知识迁移到下游任务,以改善低资源任务,对低资源语言处理也非常有利。第三,预训练模型在几乎所有 NLP 任务中都取得了目前最佳的成果。最后,这个预训练模型+微调机制具备很好的可扩展性,在支持一个新任务时,只需要利用该任务的标注数据进行微调即可,一般工程师就可以实现。

NLP领域的预训练任务模型影响图如下:

3. 小样本学习(few shot learning)

小样本学习(Few-Shot Learning)是 元学习(meta learning)的一种。

小样本学习概念可追溯到2000年初,产生的主要原因在于,目前的深度学习方法与人类的感知形成鲜明对比,样本效率很低——甚至一个孩子在看到一张照片后就能认出长颈鹿,而深度学习可能需要上亿张图片才能正确将长颈鹿分类出来。虽然微调(finetune)一个预先训练好的模型是实现高样本效率的一个流行策略,但这是事后理解。

事实上,现有的机器学习和深度学习模型普遍无法取得良好的样本外表现,用小样本训练的模型很容易陷入对小样本的过拟合以及对目标任务的欠拟合。但基于小样本的模型训练又在工业界有着广泛的需求(单用户人脸和声纹识别、药物研发、推荐冷启动、欺诈识别等样本规模小或数据收集成本高的场景),小样本学习通过将有限的监督信息(小样本)与先验知识(无标记或弱标记样本、其他数据集和标签、其他模型等)结合,使得模型可以有效的学习小样本中的信息。

小样本学习定义:给定一个 特定于任务的包含 少量可用的有监督信息 的数据集和与 不相关的辅助数据集,目标是为任务构建函数,该任务的完成利用了中很少的监督信息以及中的知识,最终将输入映射到目标任务

其中:

- 数据集与 辅助数据集中的类别是正交的,即

- 如果 中覆盖了 T 中的任务,即 ,此时 FSL 问题将成为传统的 大样本学习 问题

扩展: - 中包含一部分无标签数据半监督学习

- ,即辅助信息是与任务是无关的

小样本学习希望模型在已经学习了大量的数据后,遇到了新类别时,可以通过少量样本快速学习。即小样本学习重点在于抽取通用特征和特有特征。

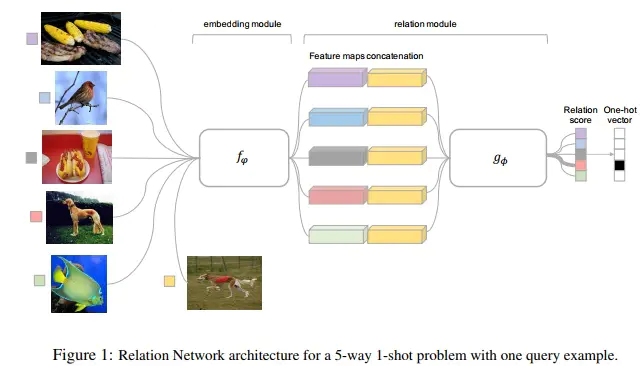

形式化来说,few-shot 的训练集中包含了很多的类别,每个类别中有多个样本。在训练阶段,会在训练集中随机抽取 C 个类别,每个类别 K 个样本(总共 CK [笛卡尔积]个数据,K值非常小,取值一般为1~20),构建一个 meta-task,作为模型的支撑集(support set)输入;再从这 C 个类中剩余的数据中抽取一批(batch)样本作为模型的预测对象(batch set)。即要求模型从 CK 个数据中学会如何区分这 C 个类别,这样的任务被称为 C-way K-shot问题。 这样划分的目的在于得到一个目标预测函数,该函数能够对的待预测样本进行预测。下图是5-way 1-shot示意图:

那什么样的小样本数据集能够产生比较好的模型呢?

- 源数据和目标数据比较相近或者相似的时候,源数据上训练的模型用于目标数据的小样本学习,效果还是比较好的。

- 依据真实场景选择,如果类别是可以选的,那就选择和源数据比较近的样本;如果类别是预规定好的,可以在每个类别通过数据选择产生一些比较好的数据帮助训练。

小样本学习的方法有哪些呢?

小样本学习的先验知识来自三方面:数据、模型、算法,小样本学习的研究也都是从这三方面着手。因此,小样本学习方法大致可分为基于数据增强的方法、基于模型改进的方法、基于算法优化的方法。

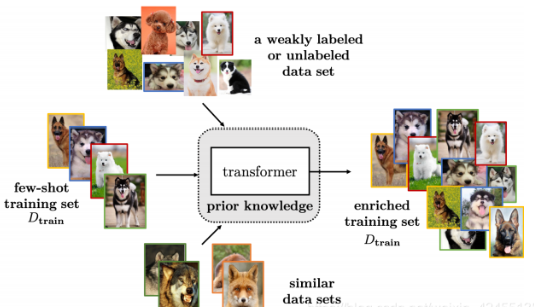

-

基于数据增强的方法。小样本学习所使用的数据增强方法主要有三个思路:1)只有小样本数据集:可以训练一个transformer学习样本之间的变化,然后使用该transformer对小样本数据集进行扩充;2)有小样本数据集+弱标注数据集:可以训练transformer从弱标注数据集中“挑选”样本来扩充小样本数据集;3)有小样本数据集+相似的数据集:可以训练一个GAN网络,通过学习给小样本数据集加上扰动来生成新样本。基于数据的方法比较容易理解,但是存在的问题是:很多工作都不具备普适性,难以迁移到别的数据集。

-

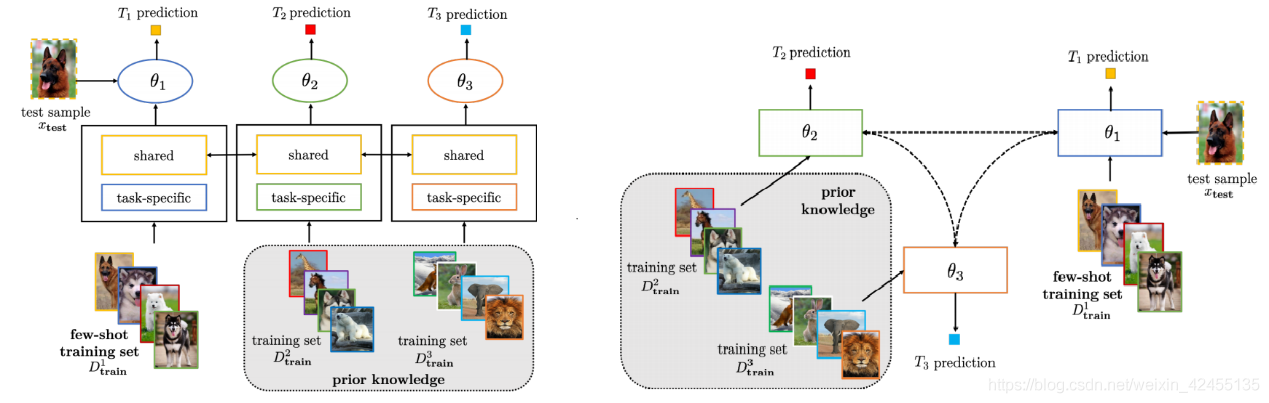

基于模型改进的方法。每个模型经过迭代都会得到近似解,而当样本有限时,在假设空间搜索解就变得困难。这类方法为了缩小假设空间,主要有四种方法:

- 多任务学习(Multitask Learning):这种模型可以处理多个任务,因此也就兼备了模型的普适性和一般性。在处理多个任务时,模型的参数可以是共享的,也可以是相关联的;

- 嵌入学习(Embedding Learning):将样本映射到一个低维度空间,从而达到了缩小假设空间的效果,然后就可以通过少量的样本求出模型在该假设空间下的近似解。根据映射到低维空间的方法又分为三类:任务特定型(结合任务的具体特点进行映射)、通用型、结合型(结合任务和通用);

- 基于外部记忆的学习(Learning with External Memory):通过对小样本数据集学习得到知识,然后存储到外部,对于新样本,都使用存储在外部的知识进行表示,并根据表示来完成匹配。这种方法大大降低假设空间;

- 生成模型(Generative Modeling):生成模型学习小样本数据集的数据分布,并可将其用于各种任务。

- 多任务学习(Multitask Learning):这种模型可以处理多个任务,因此也就兼备了模型的普适性和一般性。在处理多个任务时,模型的参数可以是共享的,也可以是相关联的;

-

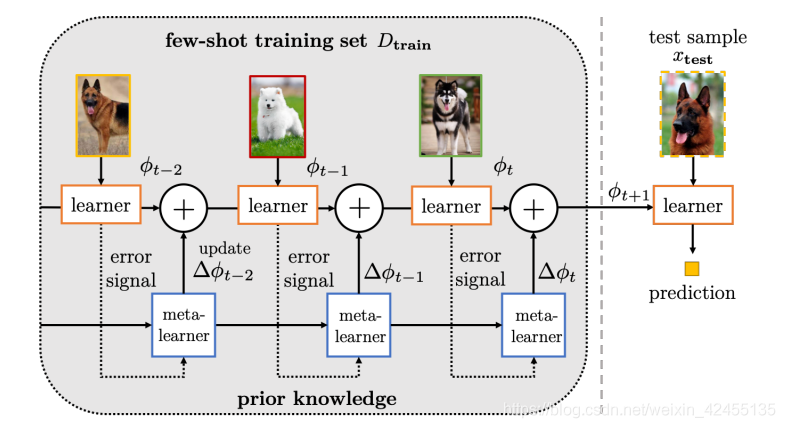

基于算法优化的方法。这类方法的核心是通过改进优化算法来更快地搜索到合适解。主要方法有三种:

- 改善已有参数。这种方法从参数初始化的角度着手,主要思路是借助已训练好的模型参数来调整小样本模型的参数,例如:在大数据集训练好模型来初始化小样本模型;聚合其他已训练好的模型到一个模型;给已训练好的模型加一些特用于小样本任务的参数;等等。

- 改善元学习参数。元学习(meta-learning)是当下很火的一个研究方向,它的思想是学习如何学习。它的结构一般是由一个底层模型和一个顶层模型组成,底层模型是model的主体,顶层模型是meta-learner。更新参数时,它除了要更新底层model,还要更新meta参数。改善策略大致有三类:1)结合不同特定任务模型参数来对新任务的参数进行初始化;2)对模型不确定性建模,以备后续提升;3)改进参数调整流程。

- 学习优化器。如下图所示,optimizer每次都迭代会更新上一次的模型参数,现在通过学习小样本数据集中每个迭代的更新值,从而应用在新的测试数据上。

小样本学习领域的最新进展可以参考:https://github.com/tata1661/FSL-Mate

4. 联邦学习(federated learning)

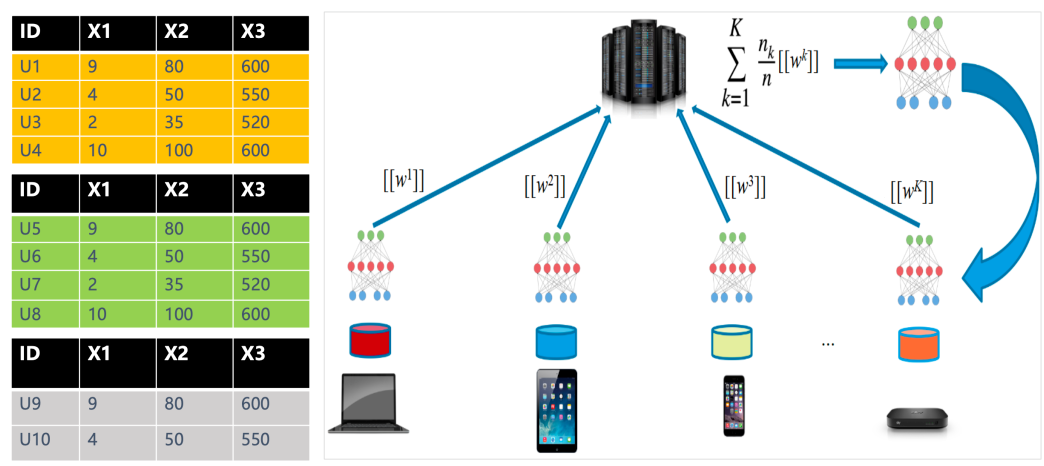

联邦机器学习(Federated machine learning/Federated Learning),又名联邦学习,联合学习,联盟学习。联邦机器学习是一个机器学习框架,能有效帮助多个机构在满足用户隐私保护、数据安全和政府法规的要求下,进行数据使用和机器学习建模。

可以参考Google绘制的关于联邦学习的漫画:https://zhuanlan.zhihu.com/p/101644082

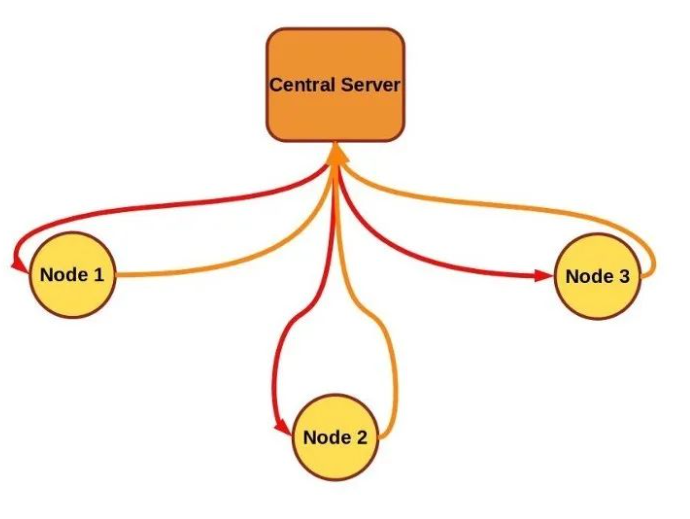

联邦学习也称为协同学习,它可以在产生数据的设备上进行大规模的训练,并且这些敏感数据保留在数据的所有者那里,本地收集、本地训练。在本地训练后,中央的训练协调器通过获取分布模型的更新获得每个节点的训练贡献,但是不访问实际的敏感数据。

据杨强教授在“联邦学习研讨会”上介绍,联邦迁移学习让联邦学习更加通用化,可以在不同数据结构、不同机构间发挥作用,没有领域和算法限制,同时具有模型质量无损、保护隐私、确保数据安全的优势。

随着公众和政策制定者越来越意识到隐私的重要性,数据实践中对保护隐私的机器学习的需求也正在上升,对于数据的访问受到越来越多的审查,对联邦学习等尊重隐私的工具的研究也越来越活跃。在理想情况下,联邦学习可以在保护个人和机构的隐私的前提下,使数据利益相关者之间的合作成为可能,因为以前商业机密、私人健康信息或数据泄露风险的通常使这种合作变得困难甚至无法进行。

联邦学习的目的是训练来自多个数据源的单个模型,其约束条件是数据停留在数据源上,而不是由数据源(也称为节点、客户端)交换,也不是由中央服务器进行编排训练(如果存在的话)。

在典型的联邦学习方案中,中央服务器将模型参数发送到各节点(也称为客户端、终端或工作器)。节点针对本地数据的一些训练初始模型,并将新训练的权重发送回中央服务器,中央服务器对新模型参数求平均值(通常与在每个节点上执行的训练量有关)。在这种情况下,中央服务器或其他节点永远不会直接看到任何一个其他节点上的数据,并使用安全聚合等附加技术进一步增强隐私。

实际数据分布可能存在以下三种情况:

- 两个数据集的用户特征(X1,X2,…)重叠部分较大,而用户(U1,U2…)重叠部分较小;

- 两个数据集的用户(U1,U2…)重叠部分较大,而用户特征(X1,X2,…)重叠部分较小;

- 两个数据集的用户(U1,U2…)与用户特征重叠(X1,X2,…)部分都比较小。

按照上述三种数据分布情况,我们将联邦学习分为了以下三类:

一、横向联邦学习。在两个数据集的用户特征重叠较多而用户重叠较少的情况下,我们把数据集按照横向(即用户维度)切分,并取出双方用户特征相同而用户不完全相同的那部分数据进行训练。这种方法叫做横向联邦学习。比如QQ和微信用户互有重叠,都有”性别“、”年龄“、”使用时间”等特征,二者结合起来可以训练出关于用户使用社交软件的一个推荐系统和数据分析系统。如下所示:

二、纵向联邦学习。在两个数据集的用户重叠较多而用户特征重叠较少的情况下,我们把数据集按照纵向(即特征维度)切分,并取出双方用户相同而用户特征不完全相同的那部分数据进行训练。这种方法叫做纵向联邦学习。比如京东&腾讯的用户有ABCDE五个用户是重叠的,腾讯有用户的“性别”&“年龄”数据,京东有“常住区域”、“消费水平”&“购物频次”的数据,二者结合起来可以使用样本数据的所有特征建立一个效果更优的模型。如下图所示:

三、联邦迁移学习。联邦迁移学习其实就是将联邦学习的思想和迁移学习的思想结合在了一起。横向联邦学习是特征一样,样本数据不一样。纵向联邦学习是样本有重叠,但是特征不一样。实际工业界还会有一些情况就是特征不一样,样本数据还没有重叠,这种情况下我们能不能联合建模?传统的方式其实就是迁移学习了,将这些数据进行升维或者降维,在子空间中可能会存在特征重叠或者用户重叠。子空间中的交互就可以进行迁移学习。那如何在迁移学习过程中保护各方的数据隐私,这时候引入联邦学习的思想即可。

附上微众银行的联邦学习白皮书:https://pan.baidu.com/link/zhihu/7BhFzRuVhrijStITJTSTJt0CVDNOd1QwdFVn==

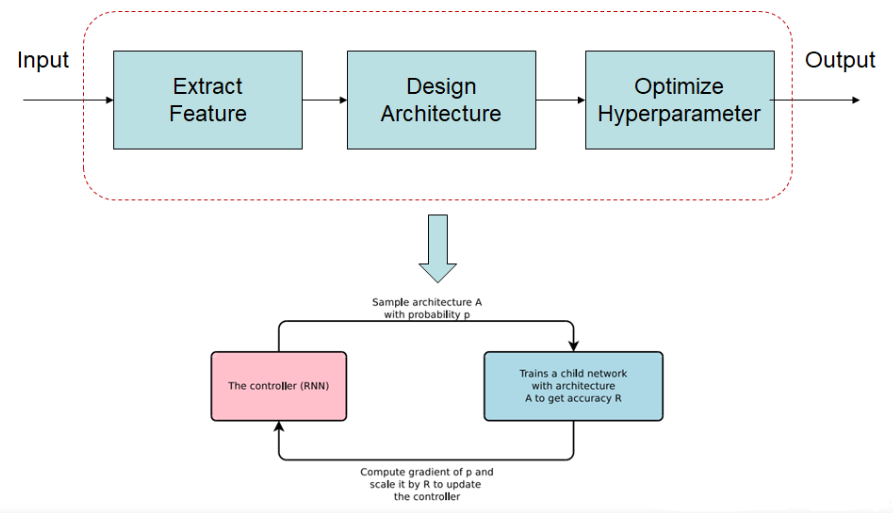

5. 自动机器学习(auto machine learning)

AutoML可以被定义为一组工具,可以使机器学习解决问题的过程自动化。其中包括炼丹师, kaggler熟悉的数据预处理,特征工程,派生,筛选等过程。

从字面意思来看,AutoML即为Auto+ML,是自动化+机器学习两个学科的结合体;从技术角度来说,则是泛指在机器学习各阶段流程中有一个或多个阶段采取自动化而无需人工参与的实现方案。其覆盖了特征工程(Feature Engineering)、模型选择(Model Selection)、算法选择(Algorithm Selection)以及模型评估(Model Evaluation)4个典型阶段,而仅有问题定义、数据准备和模型部署这三部分工作交由人工来实现。

目前的AutoML主要是基于Neural Architecture Search(NAS),即神经网络结构搜索技术,通过某种算法实现神经网络的自动生成主要包含搜索空间、搜索策略以及性能评估等方面来进行。NAS通过控制器采用生成网络结构后,模型会根据这个网络模型计算任务的正确率,然后根据这个正确率决定奖励还是惩罚,从而更新采样控制器。

NAS结构如下:

6. 区别总结

总的来说,迁移学习、元学习、小样本学习、预训练和没有讲到的多任务学习都是类似的学习任务,通过学习一部分数据来促进对另一部分数据的学习。关系应该是迁移学习>元学习、预训练、多任务学习>小样本学习。

事实上,迁移学习和元学习其实也是同一种类似的思想。你可以说元学习是强调从不同的若干小任务小样本来学习一个对未知样本未知类别都有好的判别和泛化能力的模型,但其实你想想,难道这不就是知识迁移吗?从迁移上来看,你可以说学习一个可迁移的特征或模型,可以从A迁移到B。但这些可以被迁移过提纯的东西,难道不能被叫做元知识吗?

我个人感觉预训练模型是通过大量先验知识来学习某个领域的通用知识,而小样本学习虽然只有一部分小样本可以进行学习,但是实际上小样本学习需要大量的先验知识才能保证学习的准确性。从迁移学习的角度来看,预训练模型是推导性迁移学习,后续可以根据不同的任务进行fine-tune;而小样本学习就是在已有的大量先验知识的情况下按照出现的样本的特征进行task-specified。这两者之间又如何区分界定呢?

元学习并不等于小样本学习,毕竟元学习已经存在很多年了,出现的比小样本研究要早。采用元学习和其他算法相结合,能够完成各种各样的任务,例如元学习方法实现增强学习。但是从前面的分析看,元学习是天然适合于小样本学习,所以大量的小样本的研究和元学习联系在一起。因为元学习这种策略,和其他大多方法并不冲突,并且在小样本学习上具有非常强的能力,现在很多小样本的论文都存在元学习。即使有些论文没有使用元学习,如果能够把这种训练机制添加进去的话,很可能能够提高模型的性能。

联邦学习目前说的比较火,也是发paper的一个火热领域,特别是网安学院的同学,只要能够按照联邦学习做实验基本都能发一篇B,其中的数据隐私问题也值得深入研究。

自动学习是华为天才少年所兴起的一股风潮,它强调解放人对网络结构的设计,降低人工智能的门槛,人只需要关注数据,让机器自动搜索能够最优化模型准确率的网络结构。比较著名的有国内百度的EasyDL平台、Google的AutoML,目前也出现了Auto Keras和Auto Sklearn等自动学习框架。

参考

- 一文通俗讲解元学习(Meta-Learning) https://blog.csdn.net/c9Yv2cf9I06K2A9E/article/details/121413057

- 元学习(Meta-learning)——让机器学习如何学习 https://www.jianshu.com/p/2a6e94a65c17

- 元学习(Meta-learning) https://blog.csdn.net/weixin_42187536/article/details/122094905

- 样本量极少如何机器学习?Few-Shot Learning概述 https://zhuanlan.zhihu.com/p/290011942

- 小样本学习——概念、原理与方法简介 https://www.jianshu.com/p/25720d89ed50

- 小样本学习概述 https://blog.csdn.net/weixin_42455135/article/details/110657634

- Y. Wang, J. Kwok, L. M. Ni and Q. Yao, “Generalizing from a few examples: A survey on few-shot learning”, arXiv:1904.05046, 2019

- 联邦学习(Federated Learning)详解以及示例代码 https://cbgc.scol.com.cn/news/2890927

- 什么是联邦学习/联邦学习的过程 https://blog.csdn.net/qq_15821487/article/details/120948147

- 杨强教授演讲视频:数据要素与联邦学习(附文字摘要) https://blog.csdn.net/q48S71bCzBeYLOu9T0n/article/details/120694902

- 策略产品经理必读系列—第十一讲通俗易懂讲解联邦学习 https://zhuanlan.zhihu.com/p/382177421

- 请问深度学习中预训练模型是指什么?如何得到? https://www.zhihu.com/question/327642286

- 什么是预训练模型 https://www.jianshu.com/p/d2ae1738ea83

- 预训练是什么意思 https://blog.csdn.net/weixin_48192256/article/details/120937144

- AutoML入门概述 https://blog.csdn.net/sinat_35821976/article/details/102766596

- 迁移学习概述(Transfer Learning)https://blog.csdn.net/dakenz/article/details/85954548

- 迁移学习简介 https://zhuanlan.zhihu.com/p/441967399

- 迁移学习之——什么是迁移学习(Transfer Learning) https://zhuanlan.zhihu.com/p/438117211

- 迁移学习简介与分类 https://zhuanlan.zhihu.com/p/436377664

- 模型的学习方式-迁移学习、多任务学习、小样本学习、元学习 https://blog.csdn.net/Matt_sh/article/details/106970179

- 元学习(Meta Learning)与迁移学习(Transfer Learning)的区别联系是什么? https://www.zhihu.com/question/299020462

- 元学习与小样本学习的关系 https://zhuanlan.zhihu.com/p/446750643

评论区